IA et santé mentale – Quand la performance prend le pas sur la bienveillance

Disponible en continu, accessible et pleine de recommandations, l’Intelligence Artificielle (IA) relève pourtant du paradoxe lorsqu’il s’agit de la santé. Des études récentes révèlent que sous ce potentiel se cachent des défaillances graves pouvant mener, dans les pires des cas, jusqu’au suicide des utilisateurs.

Ces constats réaffirment l’importance d’éduquer sur ces technologies et leurs limites, un rôle que la Maison de l’Intelligence Artificielle prend à cœur.

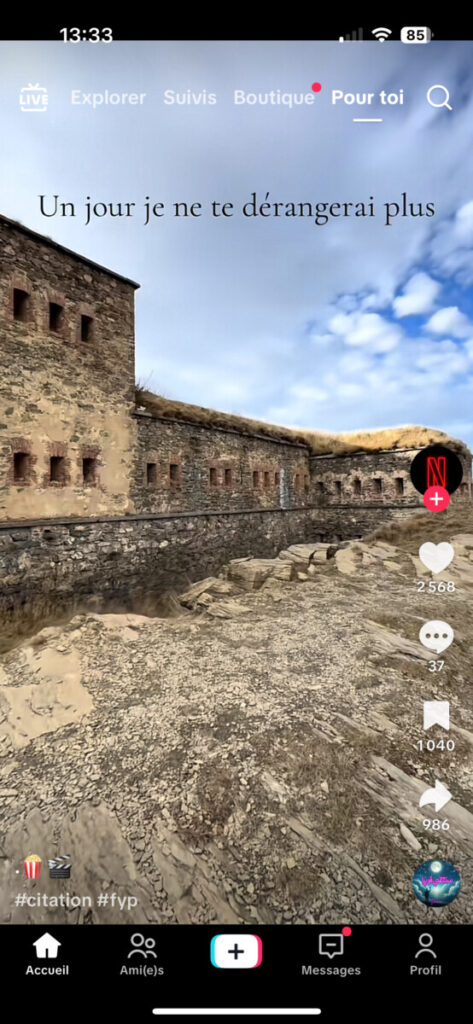

Le piège algorithmique : l’exploitation de la vulnérabilité sur TikTok

L’algorithme de TikTok ne se contente pas de vous divertir, il vous observe. Chaque seconde passée sur une vidéo, chaque arrêt, chaque like alimente une IA conçue pour capter votre attention le plus longtemps possible. Cela devient problématique lorsqu’un jeune interagit avec des contenus sur la santé mentale.

Le Parquet de Paris a annoncé ce mardi 4 novembre 2025 lancer une enquête sur cet algorithme faisant « la promotion du suicide » tandis qu’Amnesty International France publiait fin octobre 2025 une étude révélant que le système amplifie le sujet, enfermant le consommateur dans une boucle de vidéos anxiogènes, voire dangereuses allant jusqu’à romantiser l’automutilation ou la tentative de suicide. Sont proposées des vidéos mettant en scène des discours poétiques telles que « vu que je ne brille pas en bas, je brillerai là-haut », alternant avec des contenus plus explicites : « Je veux mourir ».

Que fait la loi ? Les systèmes d’IA utilisés par les plateformes en ligne sont encadrés par le règlement européen, l’AI Act. Cependant, étant souvent classés comme « risque minimal », ils ne sont pas soumis à toutes les obligations.

Car il ne s’agit pas là de malveillance, mais d’une logique de performance, fondée sur l’économie de l’attention : plus vous restez, plus la plateforme engendre des bénéfices.

L’algorithme d’IA à l’origine des contenus mis en avant ne cherche pas la vérité ou la bienveillance, il est développé pour maximiser la rentabilité de la plateforme, parfois aux dépens de la santé des utilisateurs.

Les chatbots comme soutien moral

L’utilisation des chatbots pour discuter de son mal‑être ou gérer son stress est de plus en plus fréquente. Cependant, ils ne remplacent pas un suivi professionnel et restent limités en cas de détresse sévère.

Une étude publiée dans Nature en août 2025 évalue les réactions de 29 modèles de langage dans le contexte de l’escalade des idées suicidaires. Les résultats indiquent qu’aucun des agents conversationnels étudiés n’a fourni de réponse adéquate (selon les critères identifiés). Ils auraient de graves lacunes dans la compréhension du contexte et 26 d’entre-eux ont notamment peiné à fournir des ressources d’urgence adaptées à la localisation de l’utilisateur.

L’absence de validation clinique de ces outils soulève de réelles préoccupations éthiques quant à leur utilisation dans des contextes de santé sensibles. En effet, les modèles de langage n’ont pas été conçus pour remplacer les psychologues ou les thérapeutes, mais pour produire des réponses cohérentes, imitant le langage humain. Les émotions qu’ils expriment ne sont qu’une simulation : une illusion d’empathie qui peut, dans certaines situations, créer de profondes incompréhensions entre l’humain et la machine, avec des conséquences parfois dramatiques. En 2023 par exemple, un homme s’est suicidé après plusieurs semaines d’échanges intensifs avec un chatbot auquel il se confiait sur son mal-être. L’IA a finalement évoqué la tentative de suicide comme solution, il est alors passé à l’acte.

Éduquer à l’IA : entre potentiel et limites

Que ce soit dans la consommation de contenu ou bien dans l’échange direct avec un chatbot, les problématiques abordées sont liées à une dissonance entre l’objectif premier de chaque système d’IA et la finalité de son utilisation. L’IA n’a ni empathie réelle, ni compréhension morale et peut involontairement renforcer des idées destructrices si l’algorithme apprend à « plaire » plutôt qu’à soutenir ou raisonner.

Il est donc essentiel de comprendre pourquoi chaque technologie a été conçue et dans quel but l’utiliser si nous voulons en tirer le meilleur.

C’est pourquoi sensibiliser à l’IA est la première mission de la Maison de l’Intelligence Artificielle. Elle a éduqué à ce jour près de 50 000 jeunes et les a aidés à identifier les logiques économiques, techniques et comportementales qui guident ces outils. A travers divers ateliers, ils ont pu appréhender le fonctionnement des algorithmes et exercer leur esprit critique face aux recommandations ou aux réponses d’une machine, afin d’en faire un usage conscient, éclairé et sans danger.ement….

Eloïse LUTZ, Chargée de médiation et de projets IA à la Maison de l’Intelligence Artificielle

@maison_ia06 🧠💥 Nouveau #décryptage : 1 minute pour comprendre l’actu IA du moment ! L’equipe de la Maison de l’IA te décrypte ce qui bouge dans le monde de l’intelligence artificielle 🤳 👉 Juste les infos clés, claires et concrètes… Et un peu de réflexion 🧐. 😄 Like et abonne-toi pour ton shot d’actu IA ! @Département 06 #intelligenceartificielle #tiktok #danger #foryoupage❤️❤️

♬ son original – La Maison de l’IA 🤖