Data centers : l’impasse énergétique au défi de la révolution thermique

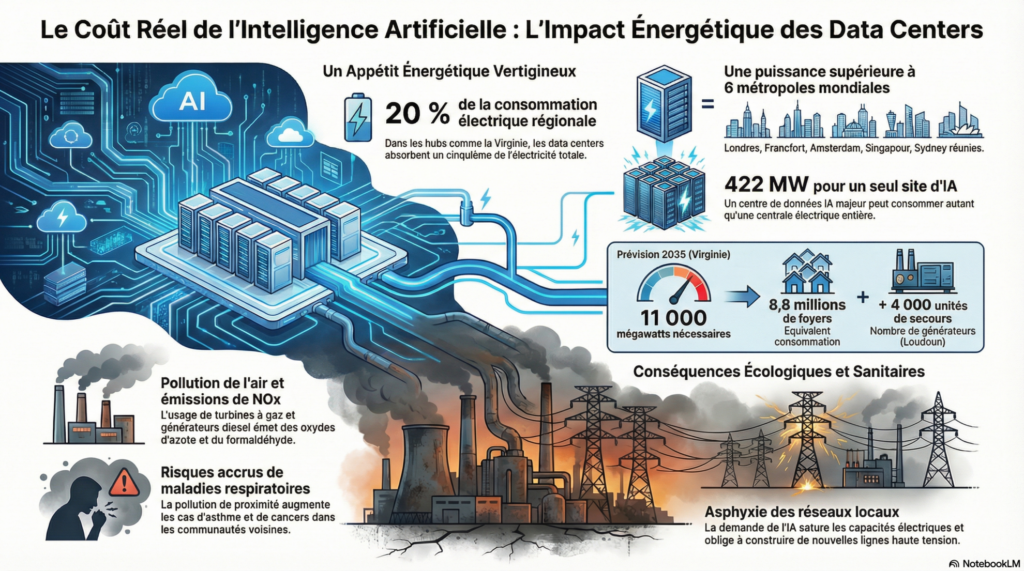

Dans l’ouest de la métropole de Washington, les comtés de Loudoun et Fairfax sont devenus la « Data Center Alley », premier pôle mondial de stockage numérique avec plus de 470 centres de données. Cette concentration sans équivalent repose sur une croissance énergétique vertigineuse : entre 2013 et 2025, Dominion Energy a raccordé en moyenne 15 nouveaux centres par an. Cette dynamique est largement alimentée par l’essor de l’IA générative, dont les besoins en calcul intensif mobilisent des milliers de GPU très énergivores, faisant du refroidissement un point critique : la climatisation par air, qui représente jusqu’à 60 % de la consommation d’un data center, montre clairement ses limites techniques et environnementales.

Face à cette impasse, certains opérateurs contournent les contraintes réglementaires, comme à Memphis, où le data center xAI d’Elon Musk a déployé des turbines à gaz très polluantes pour sécuriser son alimentation. Des industriels, à l’image de Rolls-Royce Power Systems ou de Siemens Energy, développent des solutions d’appoint au gaz plus réactives, signe d’un réseau électrique sous tension.

Le modèle dominant, fondé sur une forte concentration géographique, le refroidissement par air et la dissipation non valorisée de la chaleur, apparaît de plus en plus fragile, notamment en zones urbaines.

Il soulève aussi un enjeu de souveraineté : en France, près de 70 % des données sont hébergées aux États-Unis, accentuant une dépendance à des infrastructures énergivores et difficilement maîtrisables sur le plan environnemental.

Des alternatives thermiques émergent

Face aux limites du modèle actuel, des architectures thermiques alternatives émergent, fondées sur le refroidissement liquide direct et la valorisation de la chaleur plutôt que sur sa simple dissipation. Cette approche permet d’évacuer la chaleur au plus près des composants, de réduire drastiquement le recours à la climatisation et de réutiliser l’énergie thermique localement.

DataGreen, entreprise française basée à Sophia Antipolis et distinguée lors du World AI Cannes Festival 2026, illustre ce modèle avec des serveurs en circuit fermé affichant une réduction de plus de 50 % de la consommation énergétique et une récupération de chaleur pouvant atteindre 98 %.

Inscrite dans des dynamiques territoriales comme le SMART Deal 06 et le GREEN Deal 06, portées par le département des Alpes-Maritimes, cette approche met en lumière le potentiel des modèles thermiques circulaires.

La question des usages, angle mort du débat

Cette approche essentiellement technique laisse toutefois en suspens une interrogation plus fondamentale : celle des usages.

Le raisonnement dominant suppose une croissance continue et indiscutable des besoins numériques, portée par l’IA générative, à laquelle les infrastructures devraient s’adapter coûte que coûte. Or cette hypothèse mérite d’être questionnée.

Tous les usages justifient-ils une mobilisation permanente de ressources de calcul aussi intensives ? La généralisation de modèles toujours plus volumineux, sollicités en continu pour des fonctions parfois marginales, interroge la pertinence d’un développement fondé uniquement sur l’augmentation de la puissance disponible.

À l’instar d’autres infrastructures critiques, le numérique pourrait être amené à intégrer des logiques de priorisation, de sobriété et d’adéquation entre besoins réels et capacités mobilisées. Sans cette réflexion en amont, les innovations thermiques, aussi nécessaires soient-elles, risquent de ne traiter que les symptômes d’une demande structurellement inflationniste, sans en interroger les causes.

L’IA face à ses limites : un choix de société autant que de technologie

À mesure que l’intelligence artificielle devient une infrastructure critique, la question n’est plus seulement celle de la puissance de calcul disponible ni même de son intégration énergétique et territoriale. Elle engage également la responsabilité des usages et des utilisateurs. Le développement de l’IA repose aujourd’hui sur une sollicitation massive et parfois indiscriminée des capacités de calcul, sans toujours interroger la finalité, la pertinence ou la modération des usages. Une trajectoire soutenable du numérique suppose ainsi de dépasser la seule réponse technique pour intégrer une réflexion éthique sur les pratiques, la sobriété des usages et la sensibilisation des acteurs, entreprises, institutions comme citoyens, à l’impact réel de leurs recours à l’IA.

Le choix des architectures thermiques des data centers pèsera durablement sur les réseaux électriques, la planification urbaine et la capacité des territoires à absorber la croissance numérique. Mais sans une responsabilisation collective des usages et une culture d’un numérique plus mesuré, telle que promue par des initiatives de sensibilisation comme celles portées par La Maison de l’IA, les innovations technologiques risquent de ne traiter que les symptômes d’un modèle dont la demande resterait, elle, structurellement inflationniste.

Alexandre GENETTE, Responsable du Pôle médiation scientifique à La Maison de l’IA

@maison_ia06 🧠💥 Nouveau #décryptage : 1 minute pour comprendre l’actu IA du moment ! L’équipe de La Maison de l’IA te décrypte ce qui bouge dans le monde de l’intelligence artificielle… #Datacenters et énergie : qu’en est-il ? Zoom sur la startup DataGreen, lauréate du trophée « Alpes-Maritimes, Terre d’IA » au #WorldAICannesFestival 🤖 👉 Juste les infos clés, claires et concrètes… Et un peu de réflexion 🧐. 😄 Like et abonne-toi pour ton shot d’actu IA ! #data #foryoupage❤️❤️

♬ son original – La Maison de l’IA 🤖